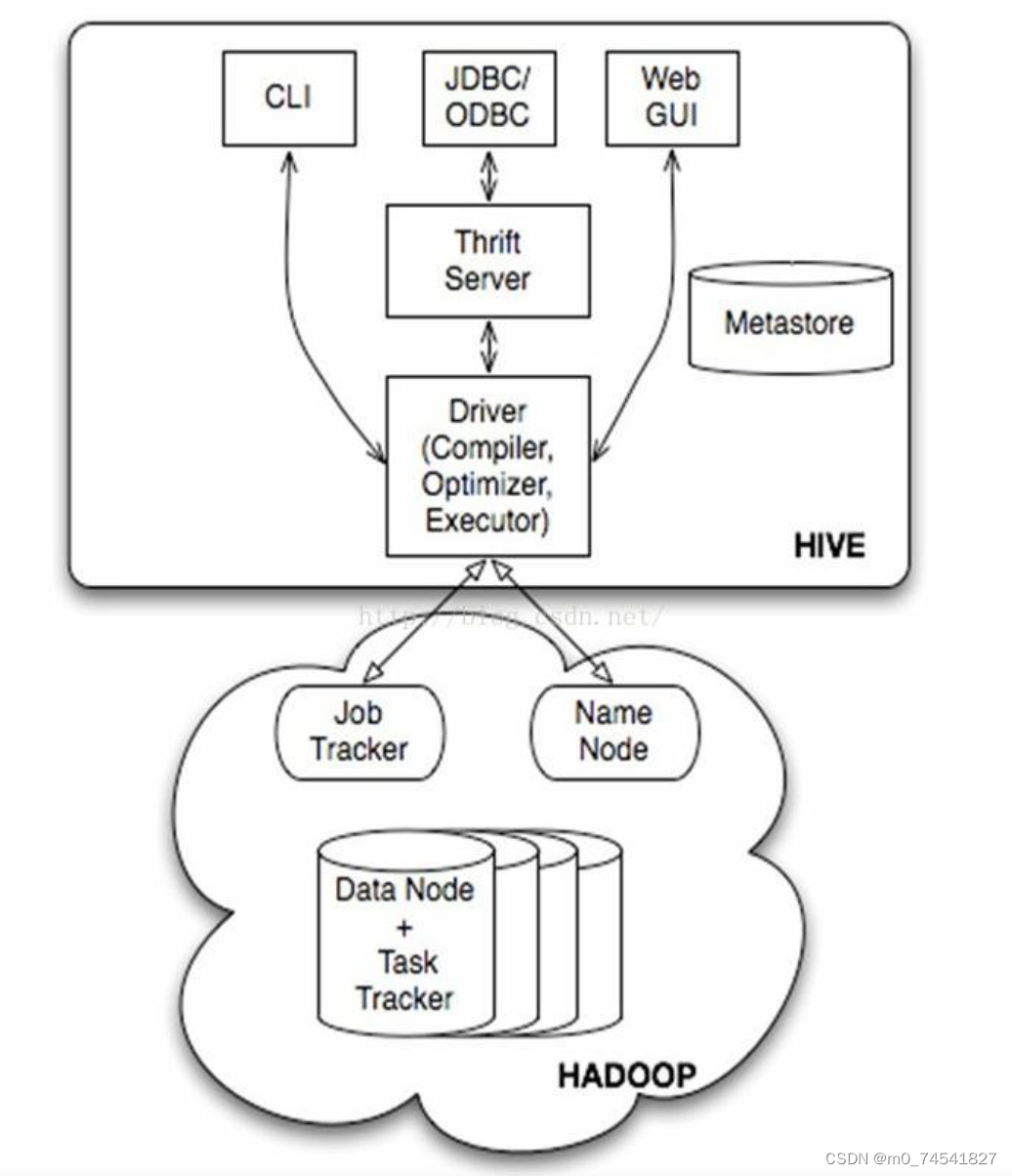

Hive的基本结构由以下几个组件组成:

- Hive Metastore:元数据仓库,用于存储表、分区、列等元数据信息。Metastore可以使用不同的存储后端,如MySQL、PostgreSQL等。

- Hive Query Language (HQL):类似于SQL的查询语言,用于编写和执行Hive查询。HQL支持各种查询操作,如SELECT、JOIN、GROUP BY等。

- Hive Driver:负责接收和解析用户提交的HQL查询,并将其转化为MapReduce或Tez等底层计算引擎可以执行的任务。

- Execution Engine:底层的计算引擎,负责执行HQL查询任务。Hive支持多种计算引擎,包括MapReduce、Tez、Spark等。

- Hive CLI/Beeline:Hive的命令行接口,用于与Hive进行交互。Hive CLI使用旧版的命令行界面,而Beeline则是Hive的新版命令行界面,提供了更多的功能和更好的用户体验。

- Hive Server:Hive的服务端组件,接收客户端的请求并处理。Hive Server可以以不同的方式运行,如独立模式、嵌入模式、远程模式等。

- Hive Warehouse:Hive的数据存储位置,通常是Hadoop分布式文件系统(HDFS)。Hive可以读取和写入HDFS上的数据,支持多种数据格式,如文本、CSV、Parquet、Avro等。

这些组件共同构成了Hive的基本结构,使得用户可以方便地通过类SQL语言对大规模数据进行查询和分析。

Hadoop的元数据与hive的元数据:

Hive和Hadoop都是大数据技术栈中常用的工具,它们都可以处理大规模数据集。虽然它们有些共同之处,但在元数据管理方面有一些不同。

- Hive是基于Hadoop的数据仓库工具,它使用结构化查询语言(SQL)来对数据进行查询和分析。Hive的元数据是以数据库的形式存储在关系型数据库中(如MySQL),而不是Hadoop分布式文件系统(HDFS)中。Hive的元数据描述了数据仓库中的表、分区、列等结构信息,以及表所对应的HDFS上的存储位置等信息。Hive使用元数据来优化查询执行计划,以提高查询性能。

- Hadoop的元数据管理是通过Hadoop分布式文件系统(HDFS)的命名空间来实现的。HDFS中的文件和目录都有相应的元数据,包括文件大小、创建时间、最后修改时间等信息。HDFS的元数据存储在NameNode中,可以通过Hadoop的命令行工具或API进行访问和管理。Hadoop的元数据主要用于存储和管理大规模数据集的基本信息,例如文件目录结构和文件块的位置等。

总结来说,Hive的元数据主要用于描述数据仓库中的表和列等结构信息,而Hadoop的元数据主要用于管理HDFS中的文件和目录的基本信息。两者虽然有不同的存储方式和用途,但在大数据处理中它们通常是紧密结合使用的。

Hive的架构